Robust Features (RFs), Non-Robust Features (NRFs)

한줄: Batch normalization (BN) 은 모델이 non-robust feature에 더 dependent하도록 shift 한다. 는 것에 대한 emprirical evidence를 제시 및 이걸 측정하기 위한 metric 제안하는 연구.

해당 연구가 BN과 robustness 관계에 대해 분석하는 첫 연구는 아니지만 기존 것들은 covariate shift 측면으로 중점을 두었었음. (BN statistics가 model robustness를 개선한다고). 그러나 이 연구는 non-robust feature 관점으로 adversarial robustness에 집중해서 분석함.

BN이 improved accruacy를 가져온다는 것은 대략 useful feature를 배운다는 것으로 해석될 수 있음 -> 그러나 BN이 주로 배우는게 RF인지 NRF인지는 unclear 함 -> 해당연구에서 BN뿐 아니라 다른 normalization 기법들에 대해 emprical분석함 -> BN은 모델이 NRF에 더 의존하도록 shift 시킨다. 그래서 adversarial robustness가 약해진다.

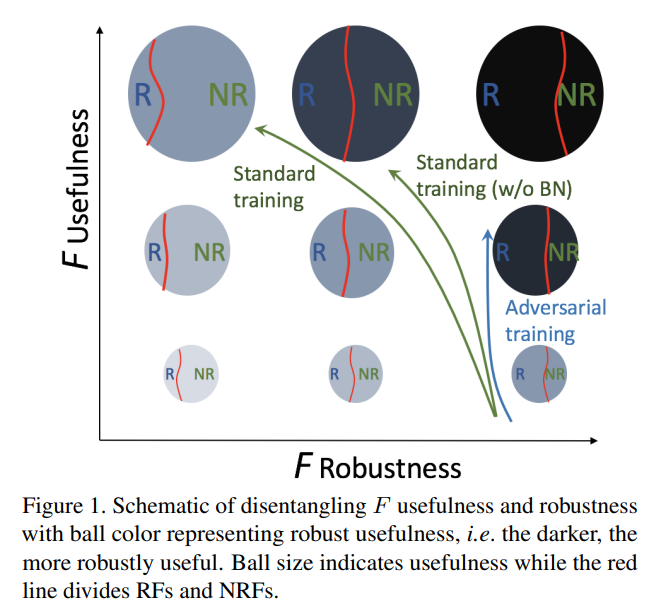

Feature robustness shift 실험을 잘보이기 위해, disentengling robust usefulness framework를 제안

Robustness와 Usefulness에 대한 관계. DNN은 초반에 RF를 배우고 NRF를 배운다.

F usefulness: clean accuracy으로 측정됨. useful feature에 대한 amount로 볼 수 있음. (그림에서 ball 크기)

F robustness: robust accruacy로 측정. ( RF와 NRF의 비율을 의미)

직접적으로 F robustness 를 측정하는 것은 매우 어려움, 그러므로 robustness와 local linearity와의 positive correlation 을 이용해서 Local Input Gradient Similarity (LIGS) 라는 metric을 제안하겠음. (local linearity로 robustness 대체)

NRF는 BN없이는 배우기 어려움을 보임 (NRF 학습은 BN에 필수적임)

모델은 RF를 먼저 배우고 다음 NRF를 배움 -> 이전에 배운 RF가 잊혀질수있음

'Boost transferable attacks' : early-stopping 쓰거나 w/o BN 이거나!